شبکه پرسپترون چند لایه در نرمافزار متلبدوشنبه 14, دسامبر 2020

شبکه پرسپترون چند لایه در نرمافزار متلب

در ادامه آموزش های سایت همیارپروژه برنامه نویسی متلب ارائه خواهد شد .آموزشها از مقدماتی تا پیشرفته ادامه دارد و ما به شما کدنویسی در نرم افزار متلب را رایگان یاد خواهیم داد. با ما همراه باشید.

شبکه پرسپترون چند لایه در نرمافزار متلب

. دیدیم که شبکههای تک لایه فقط برای طبقه بندی مسائلی که به طور خطی از هم مستقلند، کارایی دارد.

ولی ۲۵ سال تعمیم الگوریتم LMS برای شبکههای چند لایه به طول انجامید.

. ۱۹۵۹ قانون SLPR

. ۱۹۶۰ قانون LMS

. نخستین توصیف BP: پاول وربز ۱۹۷۴

. ۱۹۸۵ راملهارت، هینتون، پارکر: الگوریتم BP در شبکههای عصبی

. شبکه MLP با قانون یادگیری BP دارای بیشترین کاربرد در حل مسائل فنی_مهندسی است.

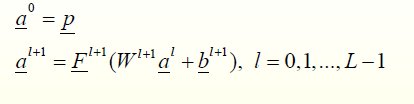

_ L تعداد لایههای شبکه

. نمایشی برای بیان ساختار شبکه چندلایه در متلب

_ R تعداد ورودیها و Si تعداد نرونها در لایه I ام

![]()

. هر نرون در شبکه MLP دو محاسبه بر عهده دارد:

_ محاسبه سیگنالی تابعی

_ محاسبه تخمین لحظهای از گرادیان خطا نسبت به پارامترهای ورودی نرون

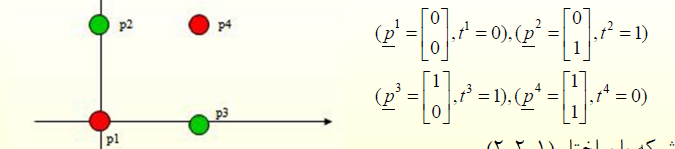

مثال ۱ الگویxor در متلب

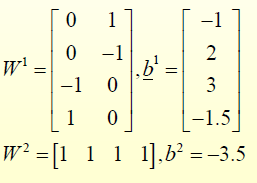

.شبکه با ساختار(۲-۲-۱)

_خط مرزی نرون اول به نحوی که الگوی p1 زیر آن و بقیه بالای آن باشند.

_ خط مرزی نرون دوم به نحوی که الگوی p4 زیر آن و بقیه بالای آن باشند.

_ خروجیهای لایه اول به ترتیب برابرند با [۱;۰] ،[۱;۱]، [۱;۱] و[۰;۱].

_ اگر لابه دوم به نوعی عمل AND را انجام دهد، مسئله حل خواهد شد.

یعنی فقط در حالتی که تمام ورودیها ۱ است، خروجی مثبت شود.

شناسایی الگو

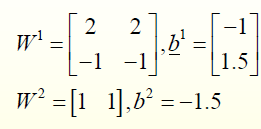

. یکی از ( بینهایت ) جوابهای مسئله به این قرار است:

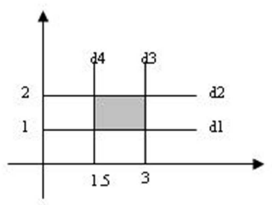

. مثال ۲:

خروجی شبکه برای بخش خاکستری ۱ و برای بقیه جاها صفر باشد.

. ناحیه مذکور توسط ۴ خط بیان میشود ساختار شبکه (۱-۴-۲)

. روش تعیین وزنها در متلب مثل قبل

_ لایه اول: معادلات خطوط

_ لایه دوم: انجام عمل AND

. جواب مطلوب:

. تمرین: درستی پاسخها تست شود.

الگوریتم BP در متلب

.تعمیمی از الگوریتم LMS

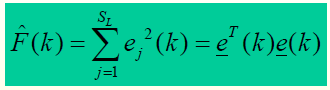

. شاخص اجرای مشابه LMS

_Sl تعداد نرونها در لایه L

. شاخص اجرایی تابعی از پارامترهای شبکه

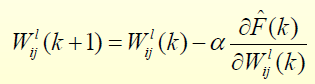

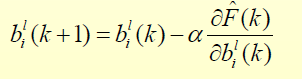

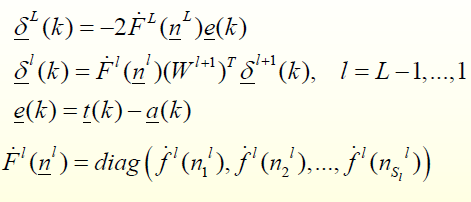

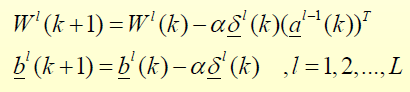

. قانون یادگیری:

_در MLS مشتقات به سادگی محاسبه میشد ولی اینجا به دلیل توابع غیر خطی کار سختتر است.

. جهت محاسبه ترم اصلاحی نیاز به سیگنال خطا داریم

_ برای نرونهای خروجی ( به دلیل قابل رویت بودن ) سیگنال خطا در دسترس است.

_ نرونهای لایه میانی ( نرون های مخفی ) قابل رویت نبوده و سیگنال خطا برای آنها قابل اندازه گیری نمیباشد.

.توجه

تمام نرونهای میانی در مقدار خطا در لایه خروجی سهیم هستند.

الگوریتم BP هر نرون را با توجه به میزان اثرش در بردار خطا تشویق یا تنبیه میکند.

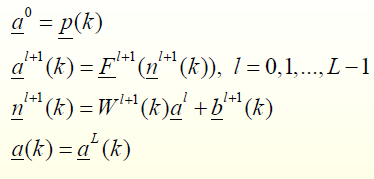

. مسیر رفت

.ملاحظه میشود که پارامترهای شبکه ثابت و بدون تغییر میمانند.

. مسیر برگشت:

_شروع کار از لایه آخر (لایه خروجی) است.

_ بردارهای حسایت خطا از لایه آخر به لایه اول برگشت داده میشوند.

_گرادیان محلی، نرون، به نرون با الگوریتم بازگشتی محاسبه میشود.

_در این مسیر نیز پارامترهای شبکه ثابت هستند.

مسیر بازگشت

. تنظیم پارامتر

توقف الگوریتم در متلب

_میانگین مربعات خطا در هر سیکل یا epoch( جمع مربعات خطابرای تمام الگوهای یادگیری) کمکتر از مقدار از پیش تعیین شده ای باشد.

دقت شود که تعداد تکرارها هر سیکل برابر تعداد دادههای یادگیری است.

_نرم گرادیان خطا از مقدار از پیش تعیین شدهای کمتر باشد.

. محدودیتBP: توابع تبدیل باید مشتق پذیر باشند.

. الگوریتم BP به صورت دستهای نیز قابل اجرا است.

در اینجا آشنایی با محیط متلب بخش صد و چهارم به پایان رسیده است و در آموزش های بعدی به مباحث دیگر آموزش متلب می پردازیم. همچنین از شما مخاطبین عزیز سایت همیارپروژه دعوت می کنم که برای انجام پروژه متلب خود آموزش های ما را دنبال نمایید.

نویسنده: زهرا رستمی

جهت سفارش پروژه به لینک زیر مراجعه نمایید :

همچنین می توانید برای ارتباط سریعتر با شماره و آیدی تلگرام زیر تماس حاصل کنید :

۰۹۱۲۹۵۴۰۱۲۲ – آیدی تلگرام : @fnalk

از طریق کلیک برروی آیکن های زیر میتوانید پروژه خود را در تلگرام و یا واتساپ برای ما ارسال کنید:

دیدگاهتان را بنویسید